Kafka - 分布式流媒体平台2025 年 1 月 23 日 | 阅读 13 分钟 分布式流处理平台简介分布式流处理平台是一个旨在跨多台机器或节点实时处理、分析和处理连续数据流的系统。这些平台通过将工作负载分布到计算机集群中,实现对大量数据的有效处理。它们支持可伸缩性、容错性和实时处理等各种功能,使其对于需要即时洞察的应用程序至关重要,例如金融交易、监控系统和实时分析。  使用 Apache Pulsar 的示例程序Apache Pulsar 是一个开源的分布式消息和流处理平台。它为实时数据流提供了一个可伸缩、低延迟且持久的解决方案。下面是一个示例程序,演示如何使用 Apache Pulsar 从流中生产和消费消息。 设置 Apache Pulsar1. 在本地模式下启动 Pulsar 在运行程序之前,请确保 Pulsar 正在运行。您可以使用以下命令在本地模式下启动 Pulsar 2. 创建 Pulsar 主题 您可以使用 Pulsar CLI 创建主题 生产者和消费者示例Pulsar 生产者 Python 代码 输出  Pulsar 消费者 Python 代码 说明

此示例演示了 Apache Pulsar 生产和消费消息的简单用例,展示了分布式流处理平台在实际场景中的核心功能。 流处理模型流处理模型旨在实时处理和分析连续数据流。这些模型定义了数据在系统中流动时如何处理,无论是应用简单的转换、按时间窗口聚合数据还是将流连接起来。  1. 无状态与有状态处理无状态处理无状态处理是指不依赖任何先前数据或上下文的操作。每个事件都是独立处理的,这意味着处理特定事件的结果不依赖于事件本身之外的任何信息。 示例:从整数流中过滤偶数。 使用 Apache Kafka Streams API(通过 Faust)的 Python 程序示例 说明

有状态处理有状态处理涉及维护跨多个事件的某些状态或上下文的操作。这允许事件的处理依赖于先前事件或累积状态。 示例:计算文本消息流中每个单词的出现次数。 使用 Apache Kafka Streams API(通过 Faust)的 Python 程序示例 输出  说明

2. 窗口和聚合窗口是一种将数据流分成有限时间块(称为窗口)的方法,以应用聚合等操作,否则这些操作在无限流上是不可能实现的。 翻滚窗口翻滚窗口是固定大小、不重叠的窗口。每个事件都恰好落入一个窗口。 示例:计算 10 秒窗口中的事件数。 使用 Apache Flink 和 PyFlink API 的 Python 程序示例 输出  说明

滑动窗口滑动窗口与先前的窗口重叠。每个事件都可以是多个窗口的一部分。 示例:计算每 5 秒滑动一次的 10 秒滑动窗口中的事件。 使用 Apache Flink 和 PyFlink API 的 Python 程序示例 输出  说明

3. 事件时间处理事件时间处理是指根据事件生成的时间(事件时间)而不是接收时间(处理时间)来处理事件。这在事件可能延迟或乱序到达的场景中至关重要。 示例:使用事件时间处理事件并处理延迟数据。 使用 Apache Flink 和 PyFlink API 的 Python 程序示例 输出  说明

4. 流连接和复杂事件处理 (CEP)流连接允许根据相关事件组合多个流。复杂事件处理 (CEP) 涉及检测跨流的模式或事件序列。 流连接示例程序 输出  说明

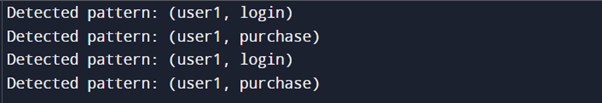

复杂事件处理 (CEP)复杂事件处理 (CEP) 涉及识别随时间推移的事件模式和序列。这对于检测欺诈、异常或操作序列等模式非常有用。 示例:使用 Apache Flink CEP 检测“登录后购买”模式。 使用 Apache Flink 和 PyFlink API 的 Python 程序示例 输出  说明

高级分布式流处理平台 随着对实时数据处理的需求持续增长,分布式流处理平台正在不断发展,以应对新的挑战并利用新兴技术。以下是一些未来趋势

1. 无服务器流处理架构无服务器架构使开发人员能够专注于编写代码,而无需担心底层基础设施。在流处理平台上下文中,无服务器架构抽象了服务器管理、扩展和配置问题。 示例:AWS Lambda 与 Kinesis Data Streams AWS Lambda 可用于处理 Kinesis Data Streams 中的事件,而无需管理服务器。 Python 程序示例 1. 创建 Lambda 函数创建一个 Python Lambda 函数来处理 Kinesis 流中的记录 说明

2. 配置 Lambda 函数

2. 边缘计算和物联网流处理边缘计算涉及在数据生成的地方(网络边缘)附近处理数据,以减少延迟和带宽使用。物联网流处理需要实时处理和分析来自众多物联网设备的数据。 示例:在 IoT 边缘设备上使用 Apache Flink Python 程序示例 1. 使用 Flink 设置边缘处理对于边缘处理,您可以在物联网设备上部署轻量级 Flink 集群。下面是一个在边缘设备上运行的 Flink 作业的概念示例 说明

3. AI 和机器学习与流数据集成将 AI 和机器学习与流数据集成,可实现实时分析、预测和决策。此趋势涉及将模型应用于流数据,以执行异常检测、推荐系统等任务。 示例:使用 Apache Flink 和 TensorFlow 进行实时异常检测 Python 程序示例 1. 准备机器学习模型假设您有一个用于异常检测的预训练 TensorFlow 模型。 2. 与 Flink 集成以进行实时预测将模型与 Apache Flink 集成以应用实时预测。 输出  说明

分布式流处理平台中的数据管理 分布式流处理平台中的数据管理涉及几个关键组件

让我们通过示例程序来探讨这些组件。 1. 数据摄取和集成数据摄取是将数据收集并引入流处理平台的过程。集成涉及将来自各种来源的数据组合成统一的流。 示例:用于数据摄取的 Kafka Connect Kafka Connect 是一个用于将各种来源的数据可伸缩、可靠地摄取到 Kafka 的工具。 使用文件源连接器设置 Kafka Connect 1. 创建连接器配置创建文件源连接器配置 (file-source-connector.properties) 2. 启动 Kafka Connect使用配置启动 Kafka Connect 说明

2. 流存储流存储涉及数据如何在流处理平台内存储和管理。例如,Kafka 将数据存储在日志中。 示例:Kafka 日志存储 Kafka 将数据存储在主题分区中,每个分区都是一个日志文件。每个日志文件都由一系列记录组成。 使用 Kafka 写入和读取日志的程序 1. Kafka 生产者 (Python)2. Kafka 消费者 (Python)说明

3. 序列化格式序列化格式用于在通过网络发送数据之前对其进行编码。常见的格式包括 Avro 和 Protobuf。 示例:Avro 序列化 1. 定义 Avro 模式2. Avro 序列化的 Python 代码消费者示例 说明

4. 模式演进和管理模式演进允许数据模式随时间变化而不会破坏兼容性。这对于管理分布式系统中的数据更改至关重要。 示例:带有 Avro 的模式注册表 1. 启动模式注册表假设您已安装 Confluent 模式注册表 2. 注册 Avro 模式 使用模式注册表 REST API 注册模式 说明

下一主题Kafka-高级流处理 |

我们请求您订阅我们的新闻通讯以获取最新更新。