机器学习中的解析解2025年2月3日 | 阅读10分钟 机器学习是一个通过从数据中发现模式和进行预测而蓬勃发展的领域;从这个意义上说,它通常以更实证的方式进行。虽然大多数机器学习技术严重依赖数值方法和近似值来解决复杂问题,但仍有一部分问题存在解析解,可以通过直接从相关的数学方程推导得出,而无需迭代算法或大量的计算。理解机器学习中的解析解可以深入了解该领域的数学基础,并有助于在更传统的统计方法与当今更现代的计算方法之间建立桥梁。 至于解析解,它表示一个封闭形式的表达式,它内在地上解决了数学问题。与数值解不同,数值解是通过迭代方法执行的引导和近似过程的结果,解析解在有限的步骤内给出结果。在机器学习的背景下,解析解通常是从一个明确定义的数学模型推导出来的,从而揭示了变量之间真实的内在关系。 机器学习中解析解的应用我们可以通过多种方式找到解析解,例如:

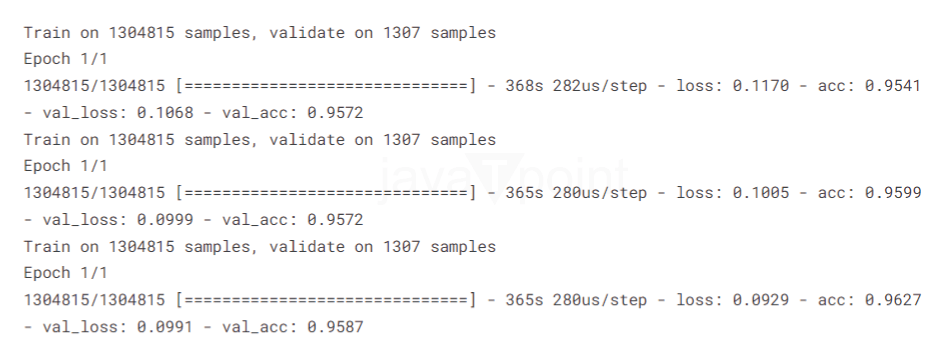

导入库我们需要一些配置值。 我们将在标点符号之前和之后用空格替换它们,以便进行分词或使文本数据准备好进行处理。   现在,我们将通过将原始文本转换为可用作模型输入(特别是对于基于神经网络的方法)的格式,来为机器学习管道准备文本数据。 现在,让我们将这些预训练的词嵌入链接到机器学习模型中;特别是,这对于 NLP 任务很有用。这使得模型能够利用关于单词含义及其相互关系的先验知识,从而在训练期间获得更好的性能并实现更快的收敛。 CNN 模型此 CNN 专门设计用于二元文本分类任务。在此模型中,卷积层用于从文本中的不同 n-gram 中提取特征,然后对这些特征进行最大池化和全连接层处理,以预测二元输出(例如,问题是真诚的还是不是)。它使用预训练的嵌入来帮助模型初始化,使其对单词语义有良好的理解,从而提高性能和收敛性。 注意力层基本上,注意力层根据学习到的注意力分数计算输入项的加权和,从而使模型能够专注于与任务相关的序列部分。特别是在自然语言处理等任务中,在执行某些任务时,并非所有单词都同等重要。 LSTM它专为序列数据上的二元分类问题而设计,例如,句子的情感或问题是否真诚。另一方面,双向 LSTM 层从序列的两个方向提取上下文信息,并且注意力机制帮助模型专注于序列中最有信息量的部分,这实际上可以提高最终预测。 GRU 层可以捕获序列中的时间依赖关系,而添加的注意力机制使模型能够仅关注序列中与提高分类数据准确性相关的部分。 使用双向 GRU 结合全局池化,可以组合有关长期依赖关系和序列最重要特征的信息并进行预测。 由于这是一个堆叠了多个双向 GRU 层并应用了注意力机制的堆叠,因此可以学习复杂的模式,并且输入序列中的关键信息将获得更大的权重,从而提高预测性能。 训练和预测输出  输出  输出  输出  输出  输出  输出  输出  输出  下一个主题机器学习中的解析解 |

我们请求您订阅我们的新闻通讯以获取最新更新。