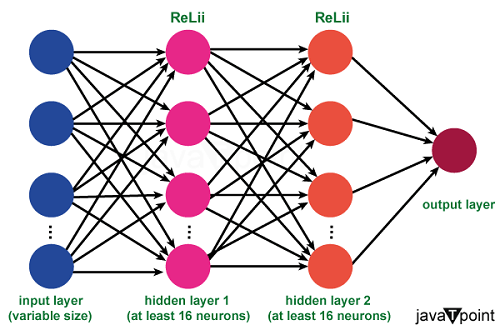

顺序神经网络2025年1月29日 | 阅读 7 分钟 引言人工智能在过去几年中取得了显著的进步,而顺序神经网络算法(SNNs)在这场进步中发挥了重要作用。由于神经网络是一种特殊类型的人工神经网络,旨在处理序列信息,因此这些网络特别适用于语音识别、自然语言处理、时间序列分析等应用。本文的其余部分将探讨顺序神经网络训练的概念框架、训练方法、应用以及正在进行的最新研究。  神经网络基础在深入研究顺序神经网络之前,了解人工神经网络的基本原理至关重要。神经网络是基于人脑皮层的结构和功能的基本数学模型。它由数百个相互连接的节点或神经元组成,分为隐藏层、输入层和输出层。网络通过调整输入和预期结果分配给每个神经元连接的权重来获得理解。 顺序神经网络的重要性传统的前馈神经网络在处理独立输入和输出的任务上表现良好,但在处理序列数据时表现不佳。文本和时间序列是序列数据的例子,它们天然地表现出时间上的相互依赖性和顺序性。而顺序神经网络能够捕捉并利用这些时间信息。 顺序神经网络架构循环神经网络 循环神经网络(RNN)是 SNN 领域的基本架构。RNN 通过保留存储有关早期输入上下文信息的隐藏状态来处理序列数据。RNN 的循环结构使其能够表示跨时间维度的依赖关系。然而,大多数人工神经网络都存在“梯度消失”问题,这使得算法难以确定长期的关联。 长短期记忆 (LSTM) 基于 LSTM 的网络旨在解决梯度消失问题。LSTM 是一种 RNN 的实例,它具有更复杂的记忆单元,使网络中的神经元能够有选择地记住或遗忘信息。由于其在捕捉长期依赖性方面的出色能力,这种架构被广泛用于各种序列任务。 GRU 网络:门控循环单元 门控循环单元(GRU)是传统 RNN 的另一种变体。GRU 在结构上比 LSTM 更简单,参数更少,但在功能上与 LSTM 有许多相似之处。尽管 GRU 结构更简单,但它在计算上比 LSTM 更有效率,并在各种应用中展现出具有竞争力的性能。 双向 RNN 与仅向前处理序列的标准 RNN 不同,双向 RNN 同时向前和向后处理序列。这使得网络能够同时从过去和未来的输入中收集信息,从而增强了网络对整个序列的上下文和依赖关系的理解。 顺序神经网络训练训练 SNN 的过程是优化网络参数,以减小预期输出和实际输出之间的差异。由于数据是序列性的,因此需要使用专门的方法来有效地训练这些网络。 时间反向传播(BPTT) 时间反向传播是传统反向传播算法的扩展,专门用于处理序列数据。在 BPTT 中,通过在时间维度上展开网络,然后使用反向传播来更新权重,所有权重都基于整个序列进行更新。然而,对于长序列,此方法会带来挑战,导致计算问题,并且难以捕捉长期依赖关系。 截断时间反向传播 为了克服 BPTT 带来的困难,通常会使用截断时间反向传播。在这种方法中,序列被分成更小的部分,并重复更新权重。虽然这减轻了一些计算障碍,但可能会降低捕捉整个序列依赖性的能力。

顺序神经网络的应用由于其适应性,顺序神经网络被广泛应用于许多不同的行业。 以下是一些值得注意的应用: 自然语言处理(NLP) SNN 彻底改变了与自然语言处理(NLP)相关的任务,特别是包括 Transformer 和残差神经网络等计算模型,它们利用了学习。其应用包括语言翻译、命名实体识别、情感分析和语言生成。 语音识别 特别是 LSTM 和 GRU 等顺序神经网络在语音识别应用中表现出色。由于它们能够精确地反映音频数据的序列结构,因此对于虚拟助手和语音控制设备等应用至关重要。 时间序列数据分析 SNN 在金融、医疗保健等多个行业用于时间序列分析。它们可以预测市场价格,识别患者健康数据中的异常情况,并根据历史数据预测模式。 视频分析 SNN 用于视频分析相关的任务,例如视频字幕和动作检测。由于其捕捉时间依赖性的能力,它们非常适合理解视频数据的动态。 无人驾驶汽车 在自动驾驶汽车领域,SNN 对于轨迹预测、物体识别和决策等任务至关重要。它们可以有效地分析来自传感器(如摄像头、雷达和激光雷达)的序列数据,从而安全地驾驶车辆。 挑战与未来方向 然而,顺序神经网络并非没有挑战。研究工作仍在努力解决梯度消失问题、捕捉长期依赖性以及计算效率低下等问题。此外,在 SNN 的可解释性方面仍有工作要做,特别是在自然语言处理等复杂应用中。 预计未来 SNN 的重要发展将包括模型设计、训练策略的改进以及 SNN 与其他人工智能方法的融合。Transformer 模型展示了混合模型如何变得越来越流行,这些模型结合了 SNN 的优势和注意力机制。此外,对神经形态计算和受生物启发的学习方法的研究,可能为增强 SNN 的性能和潜力带来新的机遇。

未来趋势和发展混合架构 将 SNN 与其他神经网络架构(包括卷积神经网络(CNN)和 Transformer 模型)集成是一个新兴趋势。混合架构利用多种网络拓扑的优势来提高特定应用的性能。在同时考虑序列和地理空间信息时,这种方法显示出巨大的潜力。 可解释人工智能的顺序模型 随着对可解释人工智能需求的日益增长,研究人员正在探索提高 SNN 可解释性的方法。通过注意力机制和模型蒸馏等技术来阐明 SNN 的决策过程,研究人员正在努力使其更透明和可信。 预训练和迁移学习 在 SNN 领域,迁移学习(将在一个任务上学到的模型应用于相关任务的过程)越来越受欢迎。在大型数据集上对 SNN 进行通用序列任务的预训练,然后针对特定应用进行微调,已被证明可以提高性能,尤其是在标记数据有限的情况下。 结论顺序神经网络已经毫无疑问地改变了人工智能领域,使机器能够以前所未有的准确性理解和解释序列数据。它们的适用范围非常广泛,涵盖了从语言处理到时间序列分析的各个领域。随着研究人员不断解决训练和可解释性方面的挑战,以及混合架构和迁移学习的蓬勃发展,SNN 的未来一片光明。当我们深入探索序列智能领域时,这些网络的进步无疑将带来更多突破性的发现和应用,从而巩固它们在不断扩展的人工智能工具库中的地位。 下一主题商业银行的优缺点 |

我们请求您订阅我们的新闻通讯以获取最新更新。